最近,我们能经常在各视频平台上看到有关AI换脸、AI翻唱的视频,例如这种:

(只要有足够的样本,AI语音合成技术几乎可以完美模仿一个人的声音)

还有这种:

视频片段来源:B站up主“用户名未填写”

是不是有种真假难辨的感觉?

随着人工智能技术的不断发展,AI换脸和AI语音合成技术已经越来越成熟,这些技术的应用范围也越来越广泛,在视频制作、虚拟现实等领域带来了很多便利。将其用在适当的地方,能够产生许多意想不到的效果。例如,已经有人在考虑利用这种技术,保留下来已故亲朋好友的音容笑貌,以作慰藉。

但是,这些技术也带来了一些潜在的风险——大家有没有想过,如果不法分子将这种技术运用到诈骗上,将会有多可怕?

想象一下,某天一个诈骗团伙,谎称你遭遇重大事故,急需一笔钱救急。你的父母可能曾听你提醒过电信诈骗的事情,一开始可能满心警惕。但接着,还不等你家中老人试探,诈骗者主动发起了视频或者语音聊天邀请。屏幕里边的人,跟自己的子女长得一模一样,说话的声音也一模一样,你说他们会不会有可能信以为真呢?要知道在以前骗子仅是发送几段文字都会有不少人上当受骗,如今面临这种情况,无法跟上科技发展脚步的老一辈们,毫无疑问会再度被诈骗团伙所迷惑。

同样的,如果有某位“领导”突然联系你需要进行一笔转账,他的声音与平时你所认识的那位领导如出一辙,你会不会照做呢?

除了上述情况之外,AI技术还可能会被用来传播虚假新闻、制造虚假证据等方面。因此,在未来会需要加强对AI技术的监管和控制,以保护个人隐私和社会安全。

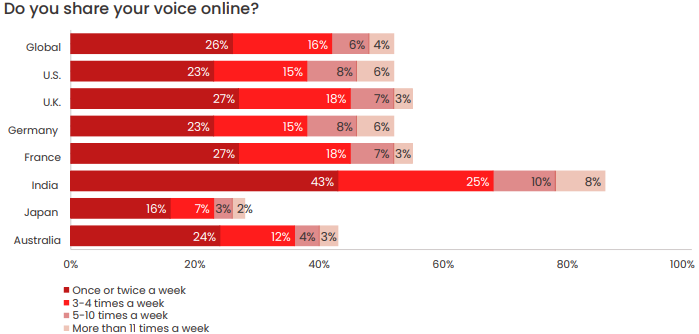

而根据美国安全公司McAfee最近的一份研究报告,约有77%的诈骗目标就栽在了AI合成语音上并且损失了财产。眼下,为了避免成为诈骗的受害者,我们也有必要警惕此类风险,以下是一些防范措施:

1、 不要轻易相信陌生人的身份。涉及到金钱来往时,即使对方能够提供视频或语音自证,也要保持警惕进一步核实身份。

2、平时尽量避免泄露个人信息。这些信息有可能会被不法分子用作合成素材。

3、注意语音和视频的细节。如果你怀疑对方正在通过AI换脸或者AI语音合成技术进行诈骗,可以仔细观察视频和语音的一些细节,比如背景、光线、声音等,辅助判断真假。

4、及时报警。当你发现自己成为了诈骗的受害者时,要及时报警,以便警方采取措施阻止不法分子继续作案。

编辑:左右里

资讯来源:McAfee

转载请注明出处和本文链接