据外媒报道,韩国科技巨头三星前不久发生了好几起由ChatGPT引起的信息泄露事件,设备测量、产量数据、内部会议等机密内容都被传输到了海外。

最初因担心可能会泄露公司内部机密信息,三星本来一直是禁止其企业内部使用ChatGPT等大型语言模型的。但从3月11日起,在认识到需要跟上技术进步后,三星的DS部门批准了使用GPT,并特别在公告中提醒员工 “注意公司内部信息安全,不要输入敏感内容”。

结果,就在三星DS部门更改政策不到20天的时间里,陆续发生了三起其所担心的信息泄露事故:其中一位员工复制了他工作中遇到的问题相关的源代码,并输入到了ChatGPT之中,向该AI询问解决方案;而另一位员工则在 ChatGPT 中输入了与设备良品率相关的程序代码,并向AI请求代码优化;最后一位员工则是将会议内容输入到ChatGPT中要求AI为其编写会议记录。

本来在ChatGPT的使用指南中,OpenAI也有明确说明输入给ChatGPT的文本内容会被用于进一步训练模型,警告用户不要提交敏感信息。而三星这三位员工的操作就意味着,他们提交的这些数据都被传输给了ChatGPT所属的美国公司OpenAI,并有可能被用作了该模型的训练数据。三星公司在知悉这些事件后,紧急采取了一系列缓解措施,例如将上传内容限制在1024字节以内等。三星目前正向事故相关职员调查原委,必要时给予处罚。

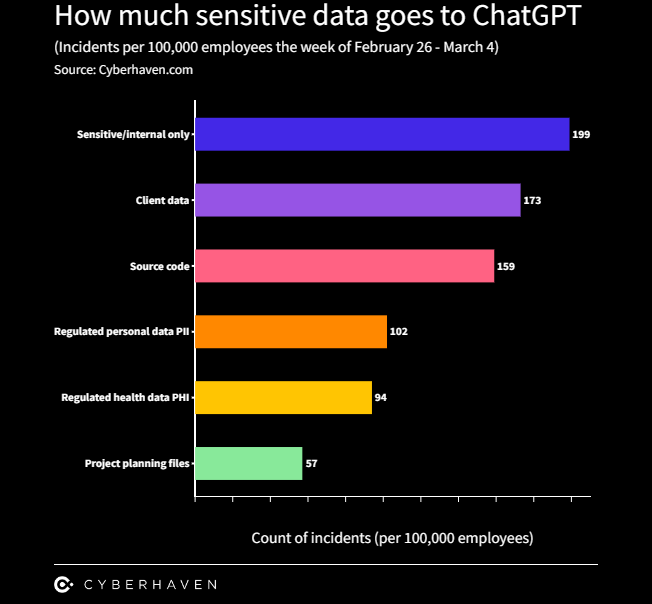

根据数据分析机构cyberhaven的一份研究报告,约有3.1%的员工会将公司机密数据复制给ChatGPT。ChatGPT能够在一定程度上提高工作效率不假,但其存在的安全隐患同样不容忽视。当前,已有多家大型企业明确禁止或限制其员工使用ChatGPT,例如摩根大通、Verizon、高盛集团、花旗集团等。意大利数据保护局也在最近声明禁止该工具的使用,除非OpenAI修改其数据收集政策。

编辑:左右里

资讯来源:economist、cyberhaven

转载请注明出处和本文链接

每日涨知识

算法(algorithm)

对输入数据执行的一组规则或过程。通常与加密函数相关,指定加密和解密的排列。

﹀

﹀

﹀